AIガバナンス態勢構築支援・サービス

昨今生成AIの急速な普及により、AIが身近に感じられ、業務において幅広く活用されるようになってきています。AIの利用により業務品質や生産性の向上が期待される一方、AIの利用には、正確性・公平性・知的財産権・セキュリティ・プライバシーなど、さまざまなリスクが存在します。

EYでは、組織においてAI活用を進めていくにあたり、そうした多様なリスクに対応したガバナンスの構築を支援します。

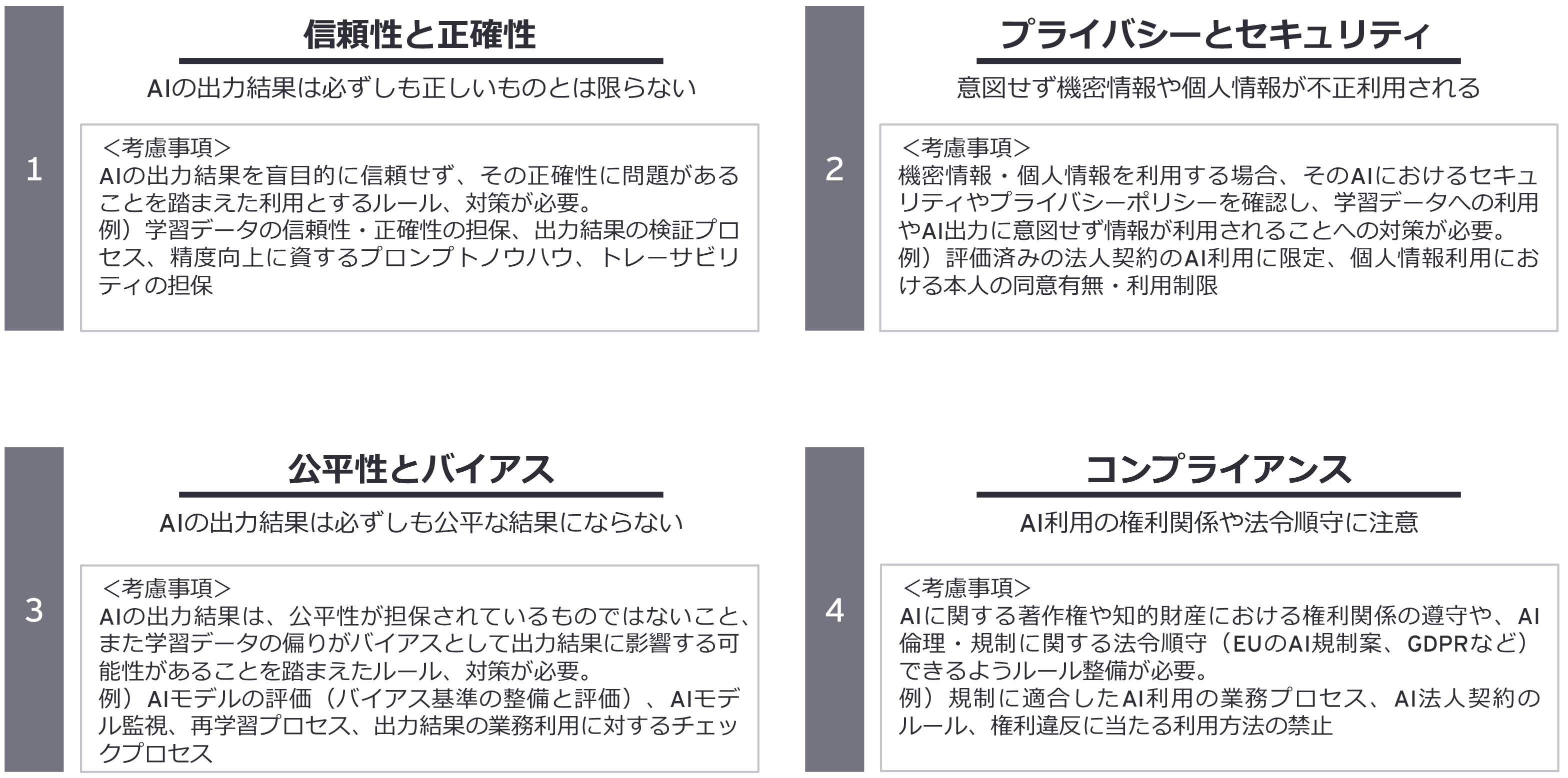

AIのリスクと考慮点

組織において、幅広い業務領域でAIを活用することにより業務品質や生産性の向上が期待される一方、AI(生成AIを含む)を利用する際には、主に4つのリスク「信頼性と正確性」、「プライバシーとセキュリティ」、「公平性とバイアス」、「コンプライアンス」が存在すると考えられます。

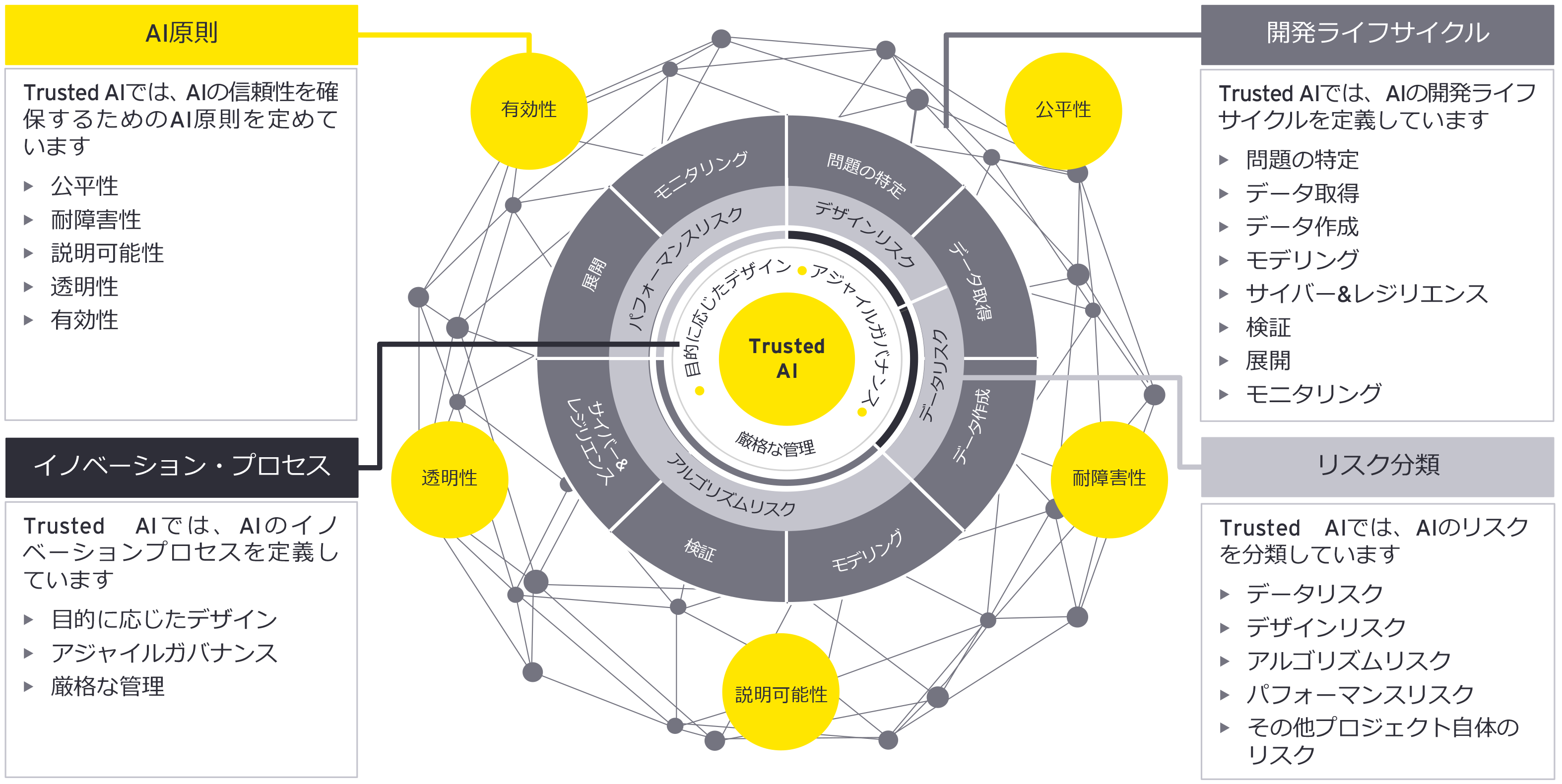

Trusted AI - EYのAIガバナンスフレームワーク

AIの信頼性や正確性などを担保するために、開発・利用・運用する際の活動を統制するための基本的な考え方や仕組みを「AIガバナンス」と呼びます。

EYはグローバルにおいて、AIガバナンスのフレームワーク「Trusted AI」を定め、態勢構築を支援しています。当フレームワークは、「AI原則」、「開発ライフサイクル」、「リスク分類」の3層によりリスクを詳細に整理し、リスク対応方針である「イノベーション・プロセス」の考え方に基づき、あるべきコントロールを定義しています。

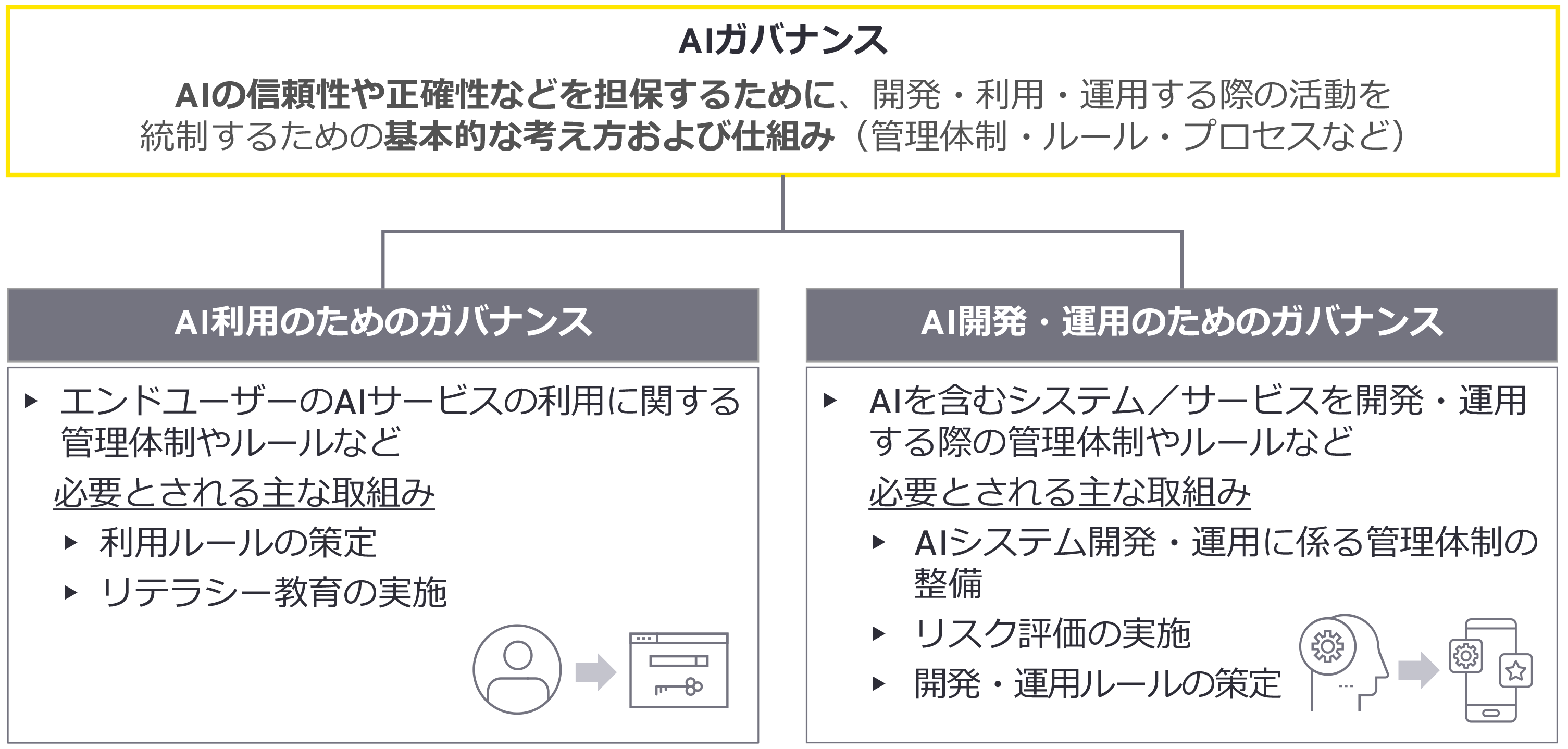

AIガバナンスの2つの側面

EYでは2つの「AIガバナンス」の整備が必要である考えています。1つ目は、利用者が誤った方法でAIを利用することにより発生するリスクを防ぐ「AI利用のためのガバナンス」、もう1つは、組織がAIモデルを含むシステムを開発・運用する際に、そのライフサイクルにおいて必要な対応を行う「AI開発・運用のためのガバナンス」です。

どちらの視点でガバナンス整備を進めるのかについては、組織におけるAI活用のフェーズによっても異なるため、マネジメントは自組織のAI活用状況を踏まえて判断する必要があります。

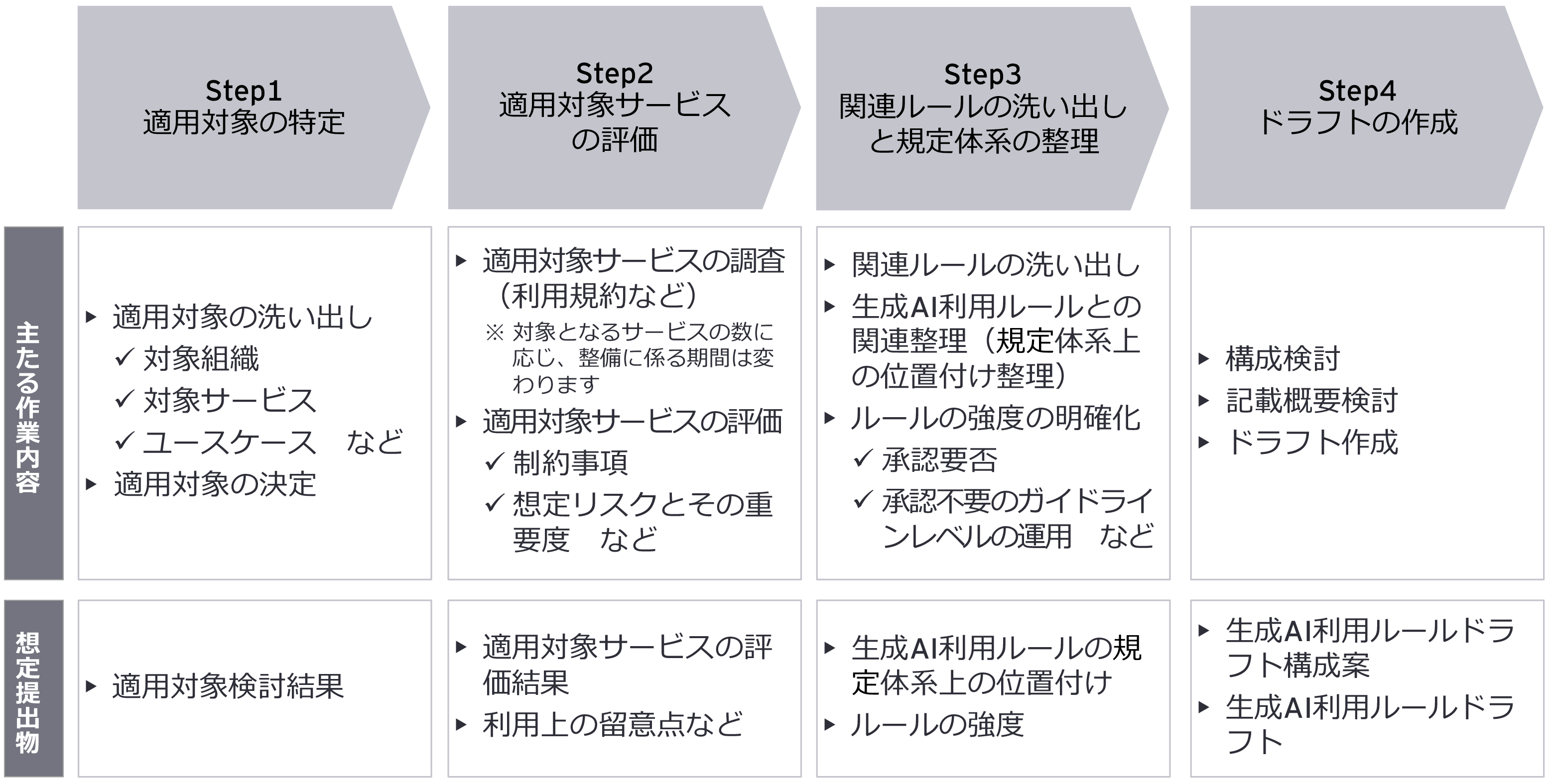

AI利用のためのガバナンス

AI利用のためのガバナンスにおいて必要な事項は、主にAI利用者が遵守すべきルールの策定および周知です。例として「生成AI利活用ガイドライン」の整備に関しては、以下のステップに示すように、適用対象組織などを特定し、適用対象サービスを評価のうえ、既存規定の体系上の位置付けを明確化し、ドラフトを作成する流れで進めます。

AI開発・運用のためのガバナンス

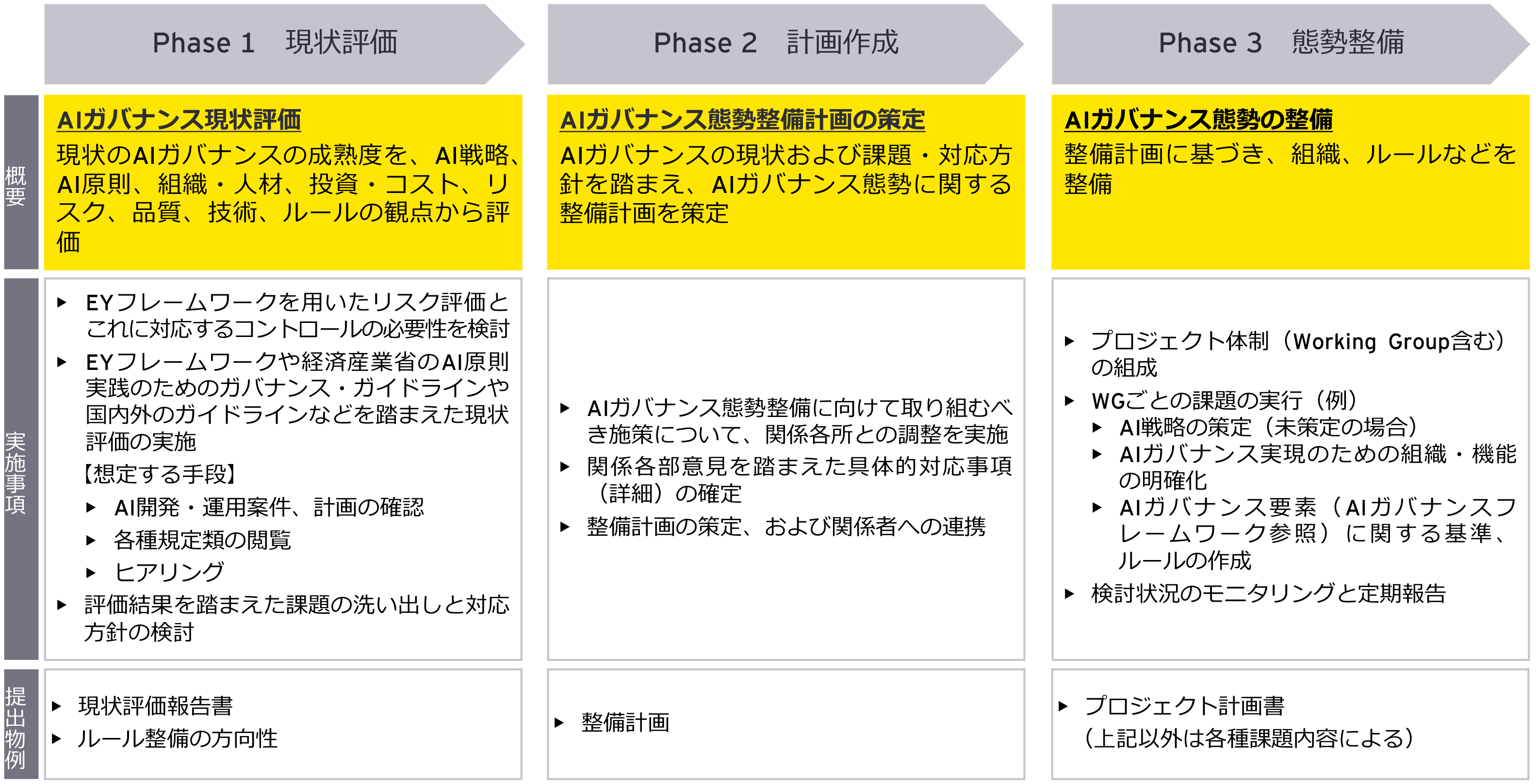

一般的に、AI開発・運用のためのガバナンスを整備するステップは以下の通りです。まず現状評価を実施した上で、計画作成および態勢整備を行います。

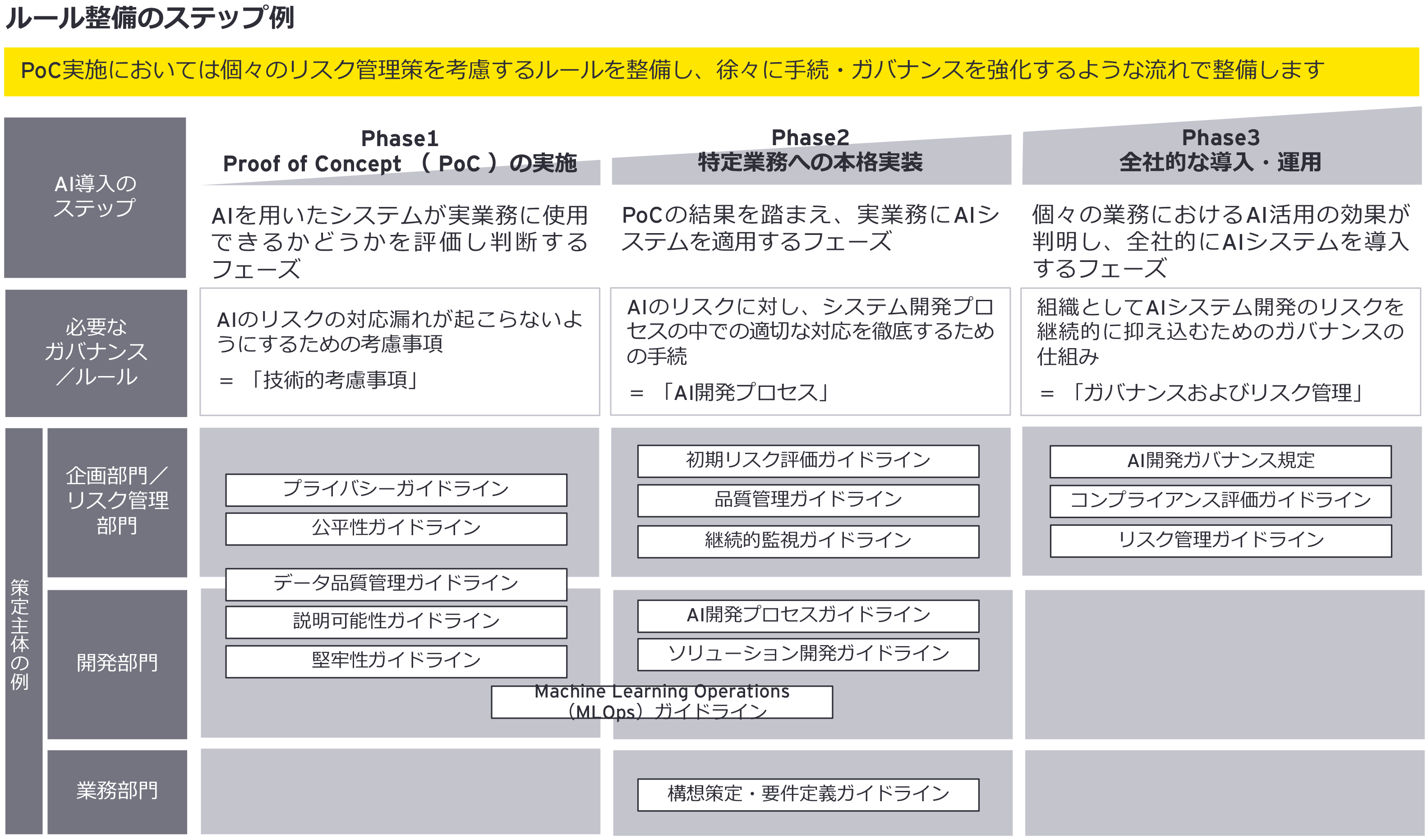

Phase2において整備計画を作る際には、一度に全てを整備しないことが肝要です。例えば、AIの開発ルールを策定するのも、以下のようにAI導入の進捗と平仄を合わせることを推奨しています。

EYの最新の見解

チーム

お問い合わせ

より詳しい情報をご希望の方はご連絡ください。