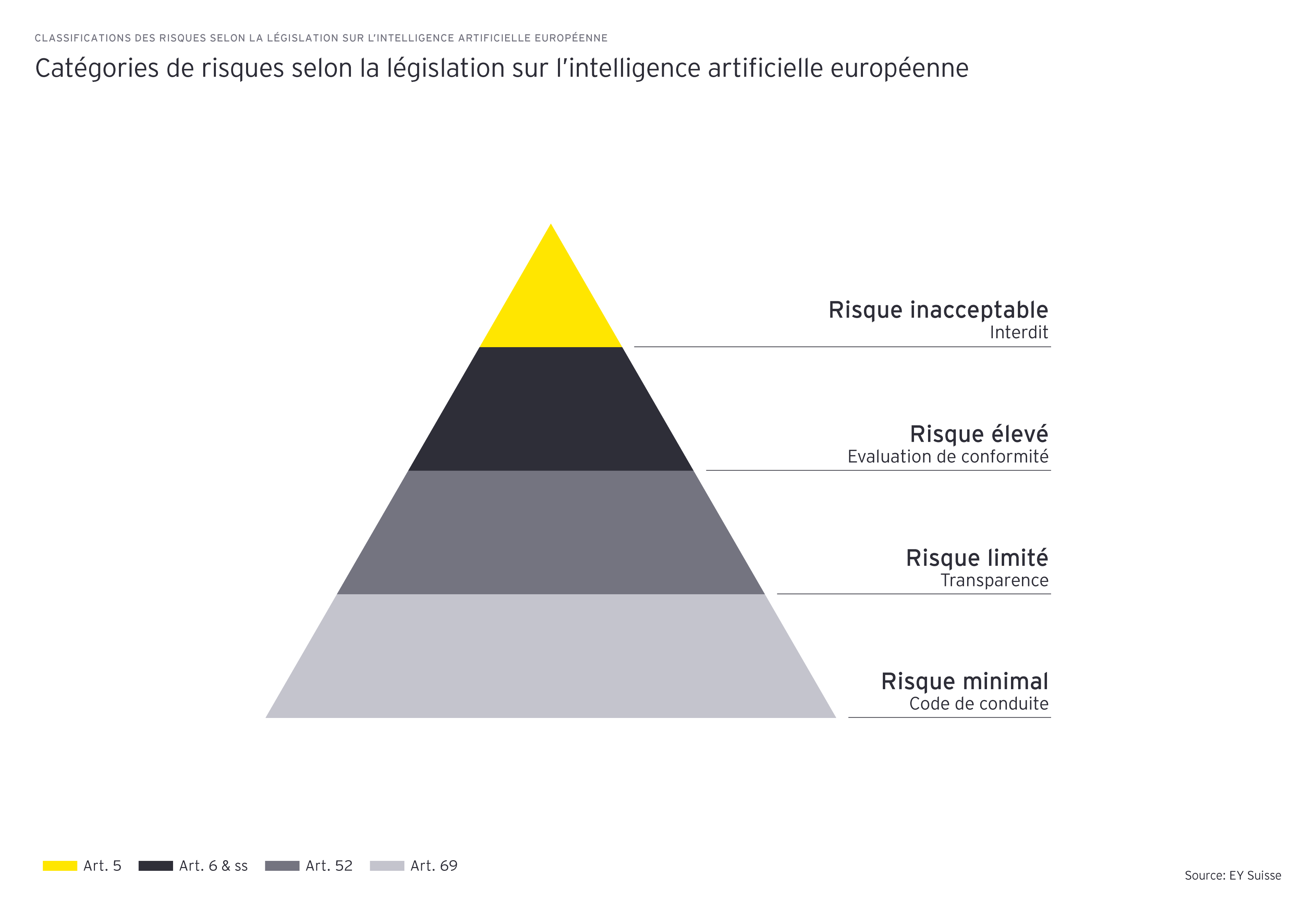

La loi donne des exemples de systèmes présentant un risque inacceptable. Les systèmes entrant dans cette catégorie sont interdits. Il s'agit par exemple de l'utilisation de l'identification biométrique à distance en temps réel dans les espaces publics ou de systèmes de notation sociale, ainsi que de l'utilisation de techniques d'influence subliminale qui exploitent les vulnérabilités de groupes spécifiques.

Les systèmes à haut risque sont autorisés, mais doivent satisfaire à de multiples exigences et faire l'objet d'une évaluation de conformité. Cette évaluation doit être réalisée avant que le système ne soit mis sur le marché. Ces systèmes doivent également être enregistrés dans une base de données de l'UE qui doit être mise en place. L'exploitation de systèmes d'IA à haut risque nécessite un système de gestion des risques approprié, des capacités de suivi et d’enregistrement des utilisations et une surveillance humaine, en plus d’un collaborateur propriétaire et responsable du système. Les données utilisées pour l'entraînement, les essais et la validation doivent faire l'objet d'une gouvernance appropriée, et des contrôles doivent être effectués pour garantir la cybersécurité, la robustesse et l'équité du modèle.

Les systèmes à haut risque sont, par exemple, les modèles liés à l'exploitation d'infrastructures critiques, les systèmes utilisés dans les processus de recrutement ou de notation des employés, les systèmes d'évaluation du crédit, le traitement automatisé des déclarations de sinistres ou la fixation des primes de risque pour les clients.

Les autres systèmes sont considérés comme présentant un risque limité ou minimal. La transparence est requise pour ces systèmes, c'est-à-dire que l'utilisateur doit être informé que ce avec quoi il interagit est généré par l'IA. Cela concerne par exemple les «chat bots» ou les «deep fakes», qui ne sont pas considérés comme présentant un risque élevé, mais pour lesquels il est obligatoire que les utilisateurs sachent que l'IA en est à l'origine.

Pour tous les opérateurs de systèmes d'IA, l’application d'un code de conduite sur l'IA éthique est recommandée. En particulier, les modèles d'IA à usage général (General-purpose AI models - GPAI), y compris les modèles de base et les systèmes d'IA générative, font l'objet d'une classification distincte. La loi sur l'IA adopte une approche par paliers pour les obligations de conformité, en faisant la distinction entre les modèles GPAI à fort impact présentant un risque systémique et les autres modèles GPAI.

Mesure 3 : Anticiper et être prêt

Si vous êtes un fournisseur, un utilisateur, un importateur, un distributeur ou une personne concernée par les systèmes d'IA, vous devez vous assurer que vos pratiques en matière d'IA sont conformes à ces nouvelles réglementations. Pour commencer à vous conformer pleinement à la loi sur l'IA, vous devez entreprendre les démarches suivantes: (1) évaluer les risques associés à vos systèmes d'IA, (2) sensibiliser, (3) concevoir des systèmes éthiques, (4) attribuer les responsabilités, (5) rester à jour et (6) établir une gouvernance formelle. En prenant des mesures proactives dès maintenant, vous pouvez éviter des sanctions potentielles importantes pour votre organisation lors de l'entrée en vigueur de la loi.

La loi sur l'IA devrait entrer en vigueur au deuxième trimestre 2024, après sa publication au Journal officiel de l'Union européenne. Des périodes de transition pour la mise en conformité seront ensuite imposées, les entreprises disposant de 6 mois pour se conformer aux exigences relatives aux systèmes d'IA interdits, de 12 mois pour certaines exigences relatives à l'IA à usage général, et de 24 mois pour parvenir à une conformité législative complète.

Quelles sont les sanctions en cas de non-respect de la loi ?

Les sanctions prévues en cas de non-respect de la loi sur l'IA sont importantes et susceptibles d'avoir de graves répercussions sur les activités du fournisseur ou du déployeur. Elles vont de 7.5 à 35 millions d'euros ou de 1 à 7% du chiffre d'affaires annuel global, en fonction de la gravité de l'infraction. Il est donc essentiel que les parties prenantes s'assurent de bien comprendre la loi sur l'IA et de se conformer à ses dispositions.

Quel est l'impact de la loi sur le secteur des services financiers ?

Les services financiers ont été identifiés comme l'un des secteurs sur lesquels l'IA pourrait avoir l'impact le plus important. La loi européenne sur l'IA contient un modèle de classification des risques à trois niveaux qui classe les systèmes d'IA en fonction du niveau de risque qu'ils représentent pour les droits fondamentaux et la sécurité des utilisateurs. Le secteur financier utilise une multitude de modèles et de processus fondés sur des données qui, à l'avenir, s'appuieront davantage sur l'IA. Les processus et les systèmes d'IA utilisés pour l'évaluation de la solvabilité ou l'évaluation des primes de risque des clients entrent dans la catégorie des systèmes d'IA à haut risque au sens de la loi sur l'IA. En outre, les systèmes d'IA utilisés pour l'exploitation et la maintenance d'infrastructures financières considérées comme critiques entrent également dans la catégorie des systèmes d'IA à haut risque, tout comme les systèmes d'IA utilisés pour l'identification biométrique et la catégorisation des personnes physiques ou la gestion de l'emploi et des employés.