Tout d’abord, les acteurs responsables doivent apprendre à maîtriser les concepts, les exigences et les conséquences de la loi sur l’IA. La direction doit être informée de cette nouvelle initiative législative.

Prêt pour la loi sur l’IA ? Voici la marche à suivre.

Avant l’entrée en vigueur de la loi sur l’IA : comprendre, examiner, planifier

Tout d’abord, les acteurs responsables doivent apprendre à maîtriser les concepts, les exigences et les conséquences de la loi sur l’IA. La direction doit être informée de cette nouvelle initiative législative. Elle doit définir des responsabilités claires pour la mise en œuvre des dispositions impératives de la loi sur l’IA. Dans la pratique, ce processus peut s’avérer complexe, car différentes fonctions de l’entreprise sont impliquées. Si la responsabilité ne peut pas être clairement attribuée, un organe réunissant ces fonctions doit être constitué pour orchestrer la mise en œuvre et faire rapport à la direction. Les parties prenantes concernées sont les suivantes :

- Chief Technology Officer (CTO) : le service informatique ou technologique est l’interlocuteur classique pour les questions numériques telles que l’IA. En revanche, le respect des exigences légales par un système de gestion approprié, comprenant des lignes directrices, des mesures, des contrôles et des obligations de documentation, ne fait typiquement pas partie de ses domaines clés.

- General Counsel Office (GCO) : étant donné que la loi sur l’IA établit des obligations légales, il peut également être envisagé d’attribuer la responsabilité de ces exigences au service juridique. La compréhension technique et la maintenance d’un système de gestion global n’entrent toutefois pas dans la sphère classique de ses compétences.

- Chief Compliance Officer (CCO) : dans le service en charge de la conformité, un Compliance Management System (CMS) réunit déjà de nombreux éléments d’un système de gestion de l’IA. De surcroît, le service de la conformité dispose déjà de canaux d’échange bien établis, à travers ce CMS, pour la communication avec les autres services. Il est en outre familiarisé aux thèmes tels que la classification des risques, l’élaboration de mesures correspondantes et la documentation connexe. En général, les exigences de la loi sur l’IA peuvent également être intégrées dans un processus réglementaire préexistant de détection et d’analyse des risques. Depuis l’instauration du RGPD, le service de la conformité possède aussi, le plus souvent, une certaine compréhension des aspects techniques que requiert la loi sur l’IA.

- Data Protection Officer (DPO) : outre le service de la conformité, la fonction de protection des données est tout à fait appropriée pour assumer la responsabilité relative à la loi sur l’IA, en particulier si elle est étoffée et assure une fonction globale de gouvernance des données, qui en plus de la protection des données au sens strict, s’occupe également de leur utilisation, de la légalité de l’environnement informatique et des risques y afférents. La plupart du temps, la fonction de protection des données sert par ailleurs d’interface entre le CTO, GCO et CCO, quel que soit l’endroit où elle est implantée dans l’entreprise. Il pourrait donc être opportun de confier la thématique de la loi sur l’IA à un(e) DPO, si ce poste a une existence autonome, et de lui affecter des ressources supplémentaires pour exercer une fonction globale de gouvernance. À défaut, le choix le plus judicieux serait sans doute un(e) CCO.

En complément de ces fonctions, des personnes issues des secteurs opérationnels ou de la direction intermédiaire qui possèdent des connaissances techniques et juridiques approfondies sur l’IA devraient aussi siéger dans un tel organe afin de pouvoir régler efficacement les questions de détail. Il ne faut pas non plus oublier de prendre en considération la situation effective de l’entreprise, y compris, par exemple, les responsabilités déjà existantes dans des domaines connexes, le cas échéant, une IA et/ou une stratégie d’innovation existante, les secteurs d’application de l’IA dans l’entreprise et le cadre réglementaire en place. De toute évidence, ces facteurs, et d’autres encore, peuvent influencer l’analyse de la responsabilité appropriée telle que décrite ci-dessus.

En marge de la définition des responsabilités, un plan d’actions clair, assorti d’un calendrier, doit être défini afin de mettre en œuvre un plan d’action de la loi sur l’IA sur la base d’une analyse des écarts. Cette analyse doit également inclure l’adéquation des processus et des lignes directrices, la formation continue prévue pour le personnel, la connaissance globale des solutions d’IA utilisées (par exemple, au moyen d’un inventaire), et quelques autres points qui seront abordés plus en détail ci-après.

À partir de l’adoption de la loi sur l’IA, un délai de deux ans est accordé pour se conformer aux exigences susmentionnées. Le plan d’action élaboré préalablement doit être mis en œuvre durant cette période.

Pendant la phase transitoire : mettre en œuvre, remanier, préparer

À partir de l’adoption de la loi sur l’IA, un délai de deux ans est accordé pour se conformer aux exigences énoncées. Le plan d’action élaboré préalablement doit être mis en œuvre durant cette période. En parallèle, il faut s’assurer en permanence si les étapes sont atteintes dans les délais impartis.

Étape 1 : Inventaire – État des lieux

Si l’entreprise ne dispose pas encore d’un inventaire, elle doit répertorier l’ensemble des logiciels, applications, algorithmes et solutions ayant un lien avec l’IA qui sont utilisés dans l’entreprise. Elle peut par exemple recourir à un éventuel système interne de gestion des actifs logiciels existant dans son service informatique. Les logiciels installés et les licences correspondantes pour tous les ordinateurs d’une entreprise sont couramment gérés dans un système de ce type.

Il est alors possible d’examiner, pour chaque logiciel installé, s’il utilise une fonctionnalité d’IA ou s’il peut potentiellement être utilisé pour la mise en œuvre d’une IA. Au lieu d’un recoupement manuel, on peut naturellement aussi effectuer des analyses de données à l’aide de bases de données ou de listes de logiciels correspondantes. En cas de doute, il convient dans un premier temps de considérer que si un logiciel offre une possibilité d’IA, cette fonction est bel et bien utilisée ou une IA a bel et bien été implémentée au moyen de ce logiciel.

Cette hypothèse doit ensuite être vérifiée et détaillée par le biais de sondages/questionnaires et de contrôles aléatoires. Étant donné que l’étendue des logiciels possibles et de leurs fonctions est extrêmement large, une telle enquête doit être conçue et analysée avec le concours de spécialistes, qui le cas échéant, disposent déjà d’une liste des fonctions d’IA possibles pour les différents logiciels et peuvent étudier les possibilités de chaque logiciel sur un plan technique.

En l’absence d’un tel système de gestion des actifs, une enquête plus large peut être menée dans l’entreprise, au moyen de questionnaires, pour déterminer si des logiciels compatibles avec l’IA sont utilisés. Hormis la portée du sondage, cela ne change rien à l’exécution. Dans le cas d’un sondage de grande envergure, toutefois, le taux de réponse initial est généralement beaucoup plus faible que si le cercle des personnes à interroger a été réduit au préalable sur la base des logiciels installés. Les frais de gestion sont donc sensiblement plus élevés pour ce type de sondage.

Indépendamment de sa forme concrète, le sondage doit toujours être organisé de façon à recueillir à la fin toutes les informations nécessaires sur les logiciels utilisés dans l’entreprise afin de pouvoir effectuer la classification des risques décrite ci-après et disposer des justificatifs pertinents pour répondre aux demandes des autorités à ce sujet.

La classification dans les catégories de risque de la loi sur l’IA doit être effectuée à la lumière de ce premier recensement et de la distinction entre les solutions d’IA et les solutions sans IA.

Étape 2 : Classification en catégories de risque et détermination des exigences

La classification dans les catégories de risque de la loi sur l’IA doit être effectuée sur la base de ce premier recensement et de la distinction entre les solutions d’IA et les solutions sans IA. Ce processus révèle également les exigences résultant de la loi sur l’IA qui doivent être mises en œuvre en conséquence. Les mesures appliquées dans l’entreprise peuvent ensuite être examinées afin de garantir la conformité du système de gestion avec les exigences de la loi sur l’IA. Les éventuelles lacunes doivent être comblées avant l’entrée en vigueur.

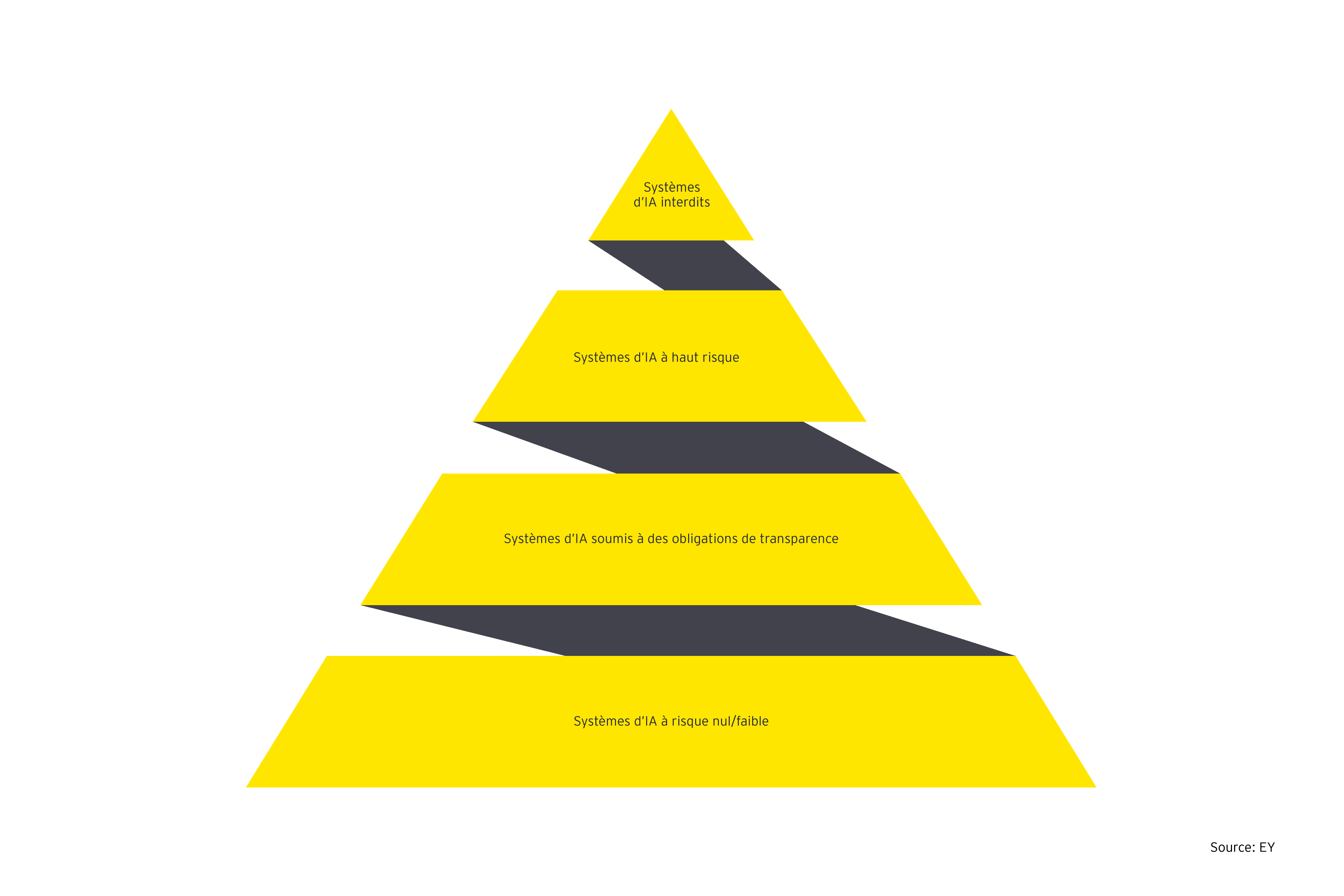

Catégories de risque et exigences

La délimitation des concepts et des catégories de risques a suscité d’intenses discussions au cours de l’élaboration du projet de loi. Dans la version actuelle, l’annexe comprend une définition et une délimitation de différentes notions et catégories de risques. Pour définir l’IA, le législateur s’est par exemple inspiré de la définition formulée par l’OCDE.

La loi sur l’IA déclare totalement illicites les systèmes d’IA qui sont perçus comme une menace incontestable pour les citoyens et citoyennes de l’UE ou qui mettent en péril la santé, la sécurité ou les droits fondamentaux des personnes à un degré tel qu’ils ne sont pas proportionnels à l’utilisation prévue. Sont notamment inclus dans cette catégorie les systèmes de notation sociale déployés par des instances publiques et les prédictions du comportement de personnes à des fins répressives (« police prédictive »).

Pour la plupart des entreprises, seules les trois catégories de risques suivantes, parmi celles énumérées par la loi sur l’IA, auront sans doute un intérêt au quotidien :

Les systèmes d’IA à haut risque sont ceux qui présentent des risques pour la santé, la sécurité ou les droits fondamentaux des personnes. Les domaines d’utilisation et les finalités concrètes qu’ils incluent précisément sont énumérés dans l’annexe à la loi. Cette liste, qui sera actualisée en permanence après son entrée en vigueur, cite actuellement, entre autres, l’emploi, la gestion de la main-d’œuvre et l’accès au travail indépendant (p. ex. pour la sélection des candidatures, la décision sur les promotions ou le contrôle des performances et du comportement de personnes employées), la gestion et l’exploitation des infrastructures critiques (p. ex. pour le pilotage de réseaux électriques ou du trafic ferroviaire), ou encore l’application de la loi, l’administration de la justice, la migration et l’asile (p. ex. pour la simplification des décisions). La surveillance biométrique des personnes appartient également à cette catégorie. Il existe en outre un risque élevé lorsqu’un système d’IA relève d’une norme européenne harmonisée pour laquelle une évaluation de la conformité (c.-à-d. une évaluation et une confirmation ou certification) est prévue. Il s’agit notamment des normes applicables aux machines, aux dispositifs médicaux, aux jouets et aux ascenseurs.

La loi sur l’IA énonce d’importantes exigences pour les systèmes à haut risque :

1. Gestion des risques

Un système de gestion des risques permettant l’identification, l’analyse et la réduction des risques doit être mis en place et appliqué aux systèmes d’IA.

2. Qualité des données

Une série d’exigences sont imposées pour l’entraînement, les tests et la validation des données utilisées. Ces données doivent par exemple être pertinentes, représentatives, exemptes d’erreurs et complètes.

3. Documentation

L’enregistrement automatique de journaux de l’activité et une documentation technique exhaustive sont obligatoires.

4. Obligations de transparence et d’information

Différentes obligations de transparence et d’information, exposées en détail dans l’annexe à la loi sur l’IA, prévalent à l’égard des utilisateurs et utilisatrices. En complément, un contrôle humain et une intervention dans les systèmes d’IA doivent être possibles.

5. Exigences techniques

Certaines exigences doivent être satisfaites en matière de sécurité de l’information. L’exactitude et la robustesse doivent atteindre un niveau approprié. À cet égard, les prescriptions détaillées figurent dans l’annexe à la loi sur l’IA.

Ce sont surtout les personnes qui exploitent la solution d’IA qui doivent se conformer aux exigences. Il leur incombe d’analyser le respect des exigences et de soumettre l’IA à une surveillance humaine. De plus, les systèmes d’IA à haut risque doivent être enregistrés dans une base de données de l’UE. L’exploitant est chargé de surveiller les systèmes d’IA et de signaler les incidents aux instances compétentes y compris après la mise en service.

Les systèmes d’IA soumis à des obligations de transparence sont les systèmes qui interagissent avec les personnes, qui utilisent la reconnaissance des émotions ou la catégorisation biométrique, ou qui génèrent des contenus artificiels présentant une ressemblance avec des personnes, des lieux ou des objets réels (hypertrucage ou deepfake). Les contenus de ce type doivent être identifiés de manière à ce que l’utilisation de l’IA apparaisse clairement et à ce que la production de contenus illicites soit impossible.

Les systèmes d’IA à faible risque sont les systèmes qui, d’après les prévisions, n’impliquent aucun risque pour les utilisateurs et utilisatrices et leurs données, tels que les solutions d’IA utilisées à des fins de tests dans des « sandboxes ». Ils sont soumis à des exigences dans le domaine de la sécurité générale des produits. La loi recommande par ailleurs l’élaboration volontaire de codes de conduite, qui s’inspirent des prescriptions édictées pour les systèmes d’IA à haut risque, mais peuvent également aller plus loin.

Cette sélection montre clairement qu’une classification dans les différentes catégories de risque n’est possible que sur une base systématique. Les systèmes à haut risque, en particulier, font l’objet d’exigences strictes et d’obligations de documentation qui nécessitent une collecte et une documentation structurées.

Outre ces systèmes, des exigences spécifiques sont prévues pour les systèmes d’IA dits à usage général (« General Purpose Artificial Intelligence », ou GPAI). La définition de ces systèmes n’a pas encore été finalisée, mais elle inclut en général les modèles d’IA qui ont été entraînés à l’aide d’un grand nombre de données utilisant l’auto-supervision non seulement pour une finalité particulière, mais aussi pour pouvoir exécuter une multitude de tâches distinctes. Sont notamment concernés les grands modèles linguistiques tels que GPT-3 et GPT-4 d’OpenAI, qui sont utilisés entre autres dans ChatGPT, ou DALL-E, également développé par OpenAI, mais aussi l’outil Bard développé par Google.

Ces modèles sont soumis à des exigences supplémentaires en matière de transparence, de respect des exigences en matière de droits d’auteur et de publication d’un « résumé détaillé » des données utilisées pour l’entrainement de ces modèles. Le législateur n’a toutefois pas encore défini ce qu’il faut entendre par « résumé détaillé ».

Si les systèmes GPAI en question ont été créés avec une puissance de calcul élevée (l’UE mentionne un seuil de 1025 opérations en virgule flottante par seconde), d’autres exigences s’appliquent sur l’évaluation des modèles, ainsi qu’une obligation d’analyses relatives aux risques systémiques liés aux modèles et des obligations de communication et de rapport à l’égard de la Commission européenne sur les incidents survenant dans le cadre de ces systèmes GPAI.

Étape 3 : Définition de calendriers clairs

Même s’il n’est pas certain que la chronologie prévue de l’entrée en vigueur de la loi sur l’IA puisse être respectée, il est conseillé de procéder dès à présent à une première évaluation des risques relatifs aux systèmes existants dans l’entreprise afin d’être préparé à une entrée en vigueur et, le cas échéant, d’adopter sans attendre les mesures adéquates pour se conformer aux exigences de la loi sur l’IA. Cette anticipation est particulièrement conseillée pour les entreprises ayant une structure complexe ou utilisant de nombreuses applications d’IA. Les entreprises qui se préparent à l’avance peuvent s’épargner quelques ennuis, et, le cas échéant, édicter à temps des réglementations qui devront être prises en compte lors de la création ou de l’acquisition d’applications d’IA. La mise en oeuvre de modifications qui exigent une intervention a posteriori dans des applications déjà implémentées et utilisées, en particulier, requiert une charge de travail importante et une concertation étroite avec les unités opérationnelles concernées. L’attribution de mandats nécessitant d’intenses efforts peu avant l’échéance peut aisément décourager les équipes, tandis que des calendriers et des instructions de travail clairs facilitent la préparation.

Plusieurs instances, telles que les organisations européennes de normalisation CEN et CENELEC, mais aussi ISO et IEC, ainsi que divers groupes industriels, travaillente d’ores et déjà sur des stratégies de bonnes pratiques et des normalisations autour de la loi sur l’IA. Avec le pacte sur l’IA de l’UE, la Commission européenne a lancé un appel aux entreprises à appliquer dès maintenant les exigences définies, à participer à l’élaboration des bonnes pratiques et à partager des informations sur la loi sur l’IA avec les autres entreprises concernées.

Étant membre d’un grand nombre de ces instances, EY peut vous aider à mieux comprendre les exigences à appliquer et vous épauler dans leur mise en œuvre.

Après l’entrée en vigueur : mettre en œuvre, surveiller, développer

La mise en œuvre des mesures susmentionnées a permis l’entrée en vigueur de la loi sur l’IA. Toutefois, le travail ne s’arrête pas là ! Les nouveaux systèmes d’IA déployés devront être surveillés en permanence et les nouvelles applications devront être développées et enregistrées conformément aux procédures et aux normes légales. Sachant que la législation sera régulièrement complétée, les processus devront également être adaptés en conséquence. La formation et l’information continues du personnel ne doivent pas non plus être négligées. Enfin, des canaux de conseils et de réclamations doivent être créés et entretenus.

Pour surveiller en permanence les nouveaux logiciels et applications, il est recommandé d’instituer un système de contrôle automatique. Les nouveaux logiciels et leurs installations peuvent par exemple être enregistrés dans ce système. Lorsqu’une entreprise installe un logiciel qui entre potentiellement dans le champ d’application de la loi sur l’IA, ce système peut envoyer des flux de travail à des cadres ou des membres du personnel spécialement formés pour procéder à la validation. De cette manière, l’utilisation de l’IA peut être contrôlé à l’avance et l’utilisation effective peut être tracée dans le système. De plus, des informations ou des questionnaires peuvent être transmis automatiquement aux utilisateurs, ou des formations en ligne sur les restrictions à respecter pour l’utilisation du logiciel concerné peuvent être lancées automatiquement.

Dans ce contexte, il est important de ne pas s’appuyer uniquement sur une approche basée sur des règles et des contrôles au sein de l’entreprise, mais d’installer, par le biais de la formation et de la communication, une culture dans laquelle le personnel est attentif aux risques et dangers potentiels de l’utilisation de systèmes d’IA et qui travaille à les minimiser ou les atténuer complètement. Les malentendus à propos de la fiabilité, le manque de transparence, ou même la discrimination involontaire par des algorithmes, renferment des risques substantiels. Une gestion responsable de l’IA permet d’utiliser de meilleurs modèles, plus performants et plus sûrs, et de continuer ainsi à se démarquer sur le marché.

Avec un système de contrôle solide, ces mesures, ou d’autres mesures similaires, permettent de satisfaire à de nombreuses exigences imposées par la loi sur l’IA et de les documenter. En outre, pour vérifier l’efficacité des contrôles, un tel système permet de déterminer des cas ciblés pour une approche d’audit efficace axée sur les risques. En même temps, l’entreprise se prépare de manière optimale à d’éventuels contrôles externes de la conformité de la loi sur l’IA, ce qui peut également constituer un argument distinctif face à la concurrence tant qu’elle s’y prépare suffisamment tôt.

Résumé

Votre entreprise utilise-t-elle l’IA ? À cette évocation, beaucoup pensent aux véhicules de livraison ou aux robots de maintenance autonomes et donnent d’instinct une réponse claire. Mais posons la question autrement : votre service marketing utilise-t-il un système permettant d’envoyer une publicité personnalisée à la clientèle ? Quels modèles votre service commercial utilise-t-il pour prévoir les ventes ? Comment votre service du personnel trie-t-il les candidatures ? Ce sont là autant d’applications potentielles de l’IA qui seront bientôt soumises à la loi sur l’IA de l’Union européenne.